Análisis clínicos sin salir de casa 🔬

Descubre más

Ofertas del día

Ver TodoDucray Melascreen Crema De Manos Fps50+ Contra El Fotoenvejecimiento 50 Ml

$345

Oferta del día

Envío gratis

Destacados

Kit de diagnóstico a domicilio

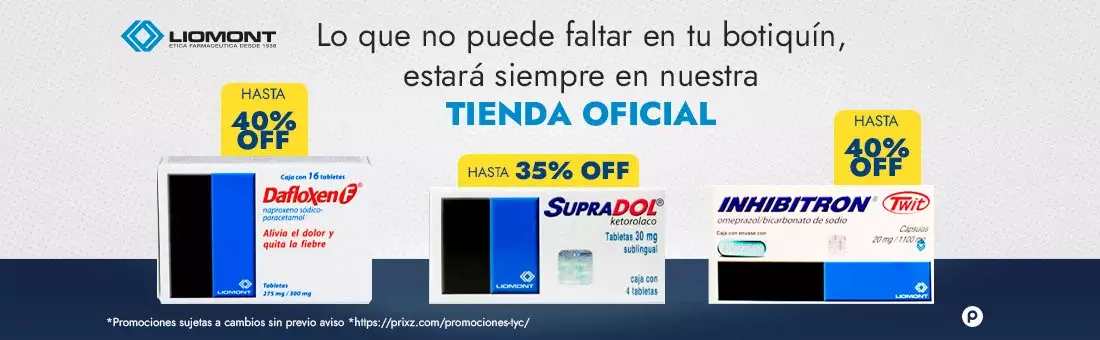

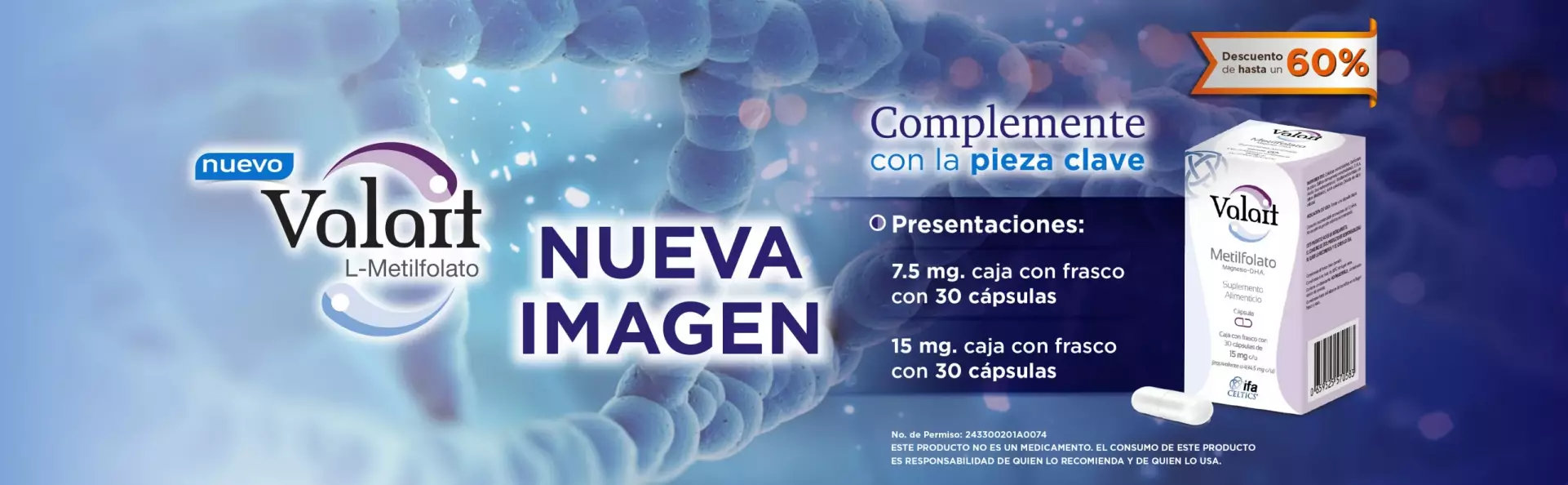

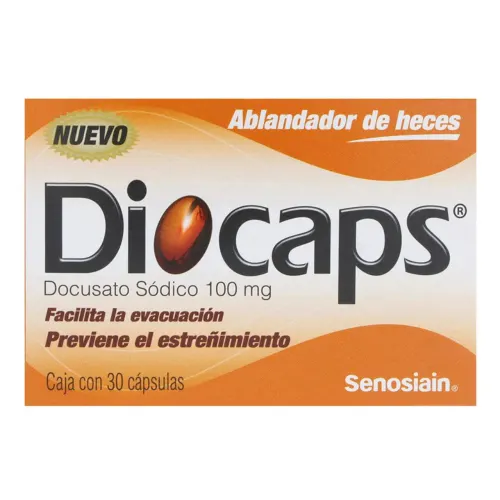

Tiendas oficiales

"Prixz en los medios"

Prixz cerrará 2022 con tres nuevos centros de reparto de última milla

Farmacia digital busca convertirse en próximo unicornio mexicano

"La insignia de Prixz siempre ha sido la de crecer"

Esta startup de salud levantó su serie A y entró a la antesala de los unicornios mexicanos

Prixz, el futuro unicornio mexicano